From f3f90f7b90979d56489d65297342b401b15ec31e Mon Sep 17 00:00:00 2001

From: binary-husky <96192199+binary-husky@users.noreply.github.com>

Date: Mon, 30 Oct 2023 01:10:45 +0800

Subject: [PATCH 1/6] Update README.md

---

README.md | 81 +++++++++++++++++++------------------------------------

1 file changed, 28 insertions(+), 53 deletions(-)

diff --git a/README.md b/README.md

index c93b57a1..83f385c9 100644

--- a/README.md

+++ b/README.md

@@ -7,18 +7,18 @@

#

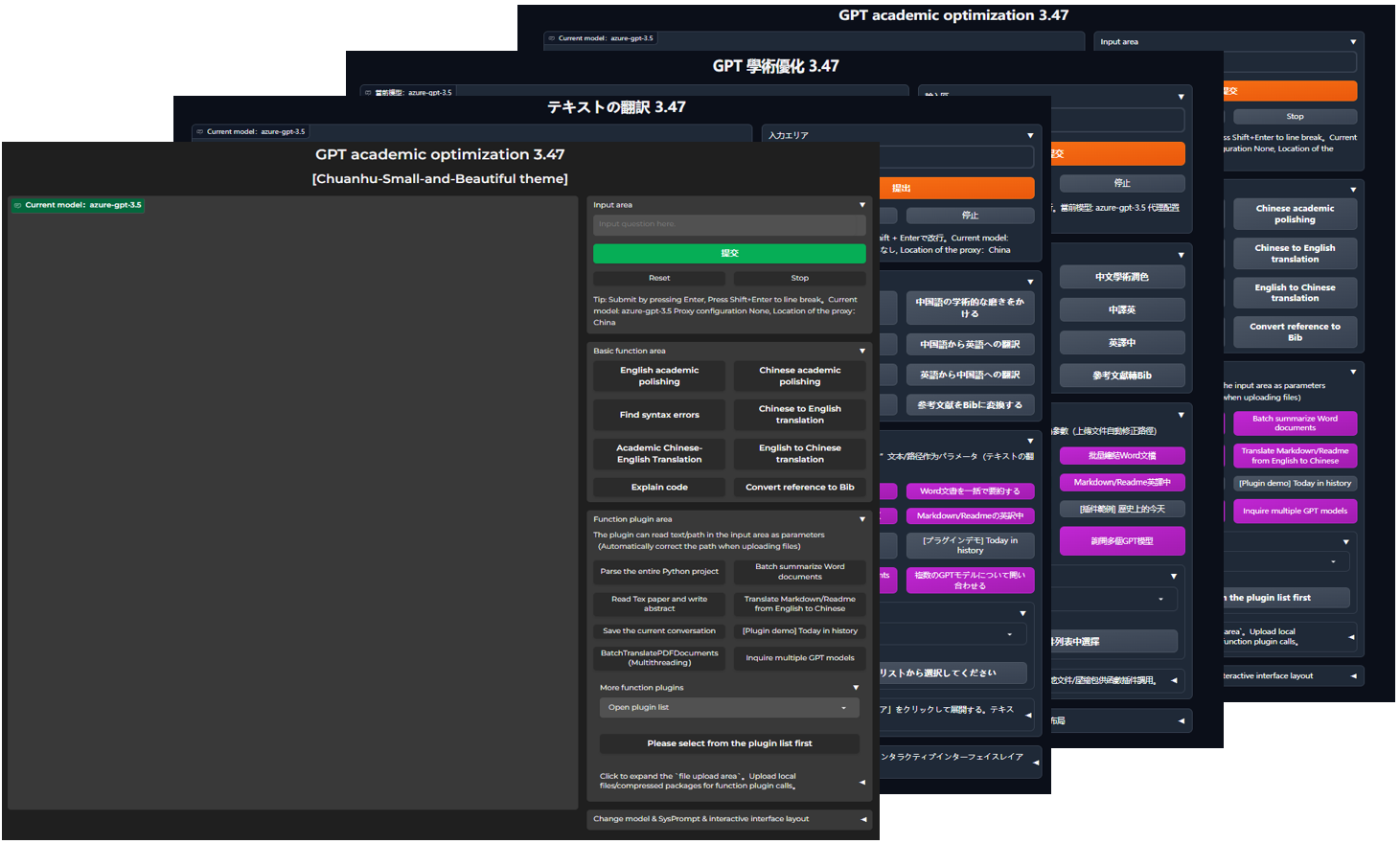

GPT 学术优化 (GPT Academic)

-7. 新增MOSS大语言模型支持

-

-7. 新增MOSS大语言模型支持

-

-

-

===>

-11. 语言、主题切换

+10. 语言、主题切换

@@ -348,7 +324,6 @@ GPT Academic开发者QQ群:`610599535`

### IV:本项目的开发分支

1. `master` 分支: 主分支,稳定版

-

2. `frontier` 分支: 开发分支,测试版

From 9fb29f249bd146e70343d51c29795eff895896bb Mon Sep 17 00:00:00 2001

From: Zorn Wang

Date: Mon, 30 Oct 2023 19:20:05 +0800

Subject: [PATCH 2/6] =?UTF-8?q?Feature:=20=E6=B7=BB=E5=8A=A0=E7=99=BE?=

=?UTF-8?q?=E5=BA=A6=E5=8D=83=E5=B8=86=E6=96=87=E5=BF=834.0=E5=A4=A7?=

=?UTF-8?q?=E6=A8=A1=E5=9E=8B=E6=94=AF=E6=8C=81?=

MIME-Version: 1.0

Content-Type: text/plain; charset=UTF-8

Content-Transfer-Encoding: 8bit

---

config.py | 2 +-

request_llm/bridge_qianfan.py | 5 +++--

2 files changed, 4 insertions(+), 3 deletions(-)

diff --git a/config.py b/config.py

index abea7ea3..b4f00a63 100644

--- a/config.py

+++ b/config.py

@@ -98,7 +98,7 @@ AVAIL_LLM_MODELS = ["gpt-3.5-turbo-16k", "gpt-3.5-turbo", "azure-gpt-3.5",

# 百度千帆(LLM_MODEL="qianfan")

BAIDU_CLOUD_API_KEY = ''

BAIDU_CLOUD_SECRET_KEY = ''

-BAIDU_CLOUD_QIANFAN_MODEL = 'ERNIE-Bot' # 可选 "ERNIE-Bot"(文心一言), "ERNIE-Bot-turbo", "BLOOMZ-7B", "Llama-2-70B-Chat", "Llama-2-13B-Chat", "Llama-2-7B-Chat"

+BAIDU_CLOUD_QIANFAN_MODEL = 'ERNIE-Bot' # 可选 "ERNIE-Bot-4"(文心大模型4.0), "ERNIE-Bot"(文心一言), "ERNIE-Bot-turbo", "BLOOMZ-7B", "Llama-2-70B-Chat", "Llama-2-13B-Chat", "Llama-2-7B-Chat"

# 如果使用ChatGLM2微调模型,请把 LLM_MODEL="chatglmft",并在此处指定模型路径

diff --git a/request_llm/bridge_qianfan.py b/request_llm/bridge_qianfan.py

index be739760..bbae5630 100644

--- a/request_llm/bridge_qianfan.py

+++ b/request_llm/bridge_qianfan.py

@@ -78,8 +78,9 @@ def generate_from_baidu_qianfan(inputs, llm_kwargs, history, system_prompt):

BAIDU_CLOUD_QIANFAN_MODEL, = get_conf('BAIDU_CLOUD_QIANFAN_MODEL')

url_lib = {

- "ERNIE-Bot": "https://aip.baidubce.com/rpc/2.0/ai_custom/v1/wenxinworkshop/chat/completions" ,

- "ERNIE-Bot-turbo": "https://aip.baidubce.com/rpc/2.0/ai_custom/v1/wenxinworkshop/chat/eb-instant" ,

+ "ERNIE-Bot-4": "https://aip.baidubce.com/rpc/2.0/ai_custom/v1/wenxinworkshop/chat/completions_pro",

+ "ERNIE-Bot": "https://aip.baidubce.com/rpc/2.0/ai_custom/v1/wenxinworkshop/chat/completions",

+ "ERNIE-Bot-turbo": "https://aip.baidubce.com/rpc/2.0/ai_custom/v1/wenxinworkshop/chat/eb-instant",

"BLOOMZ-7B": "https://aip.baidubce.com/rpc/2.0/ai_custom/v1/wenxinworkshop/chat/bloomz_7b1",

"Llama-2-70B-Chat": "https://aip.baidubce.com/rpc/2.0/ai_custom/v1/wenxinworkshop/chat/llama_2_70b",

From ca7ff47fcb3105ba3134196161c3f557be693cf2 Mon Sep 17 00:00:00 2001

From: ji-jinlong <61379293+ji-jinlong@users.noreply.github.com>

Date: Wed, 1 Nov 2023 16:05:57 +0800

Subject: [PATCH 3/6] =?UTF-8?q?Update=20=E7=90=86=E8=A7=A3PDF=E6=96=87?=

=?UTF-8?q?=E6=A1=A3=E5=86=85=E5=AE=B9.py?=

MIME-Version: 1.0

Content-Type: text/plain; charset=UTF-8

Content-Transfer-Encoding: 8bit

---

crazy_functions/理解PDF文档内容.py | 2 +-

1 file changed, 1 insertion(+), 1 deletion(-)

diff --git a/crazy_functions/理解PDF文档内容.py b/crazy_functions/理解PDF文档内容.py

index f1a89a7e..4674b935 100644

--- a/crazy_functions/理解PDF文档内容.py

+++ b/crazy_functions/理解PDF文档内容.py

@@ -49,7 +49,7 @@ def 解析PDF(file_name, llm_kwargs, plugin_kwargs, chatbot, history, system_pro

gpt_say = yield from request_gpt_model_in_new_thread_with_ui_alive(i_say, i_say_show_user, # i_say=真正给chatgpt的提问, i_say_show_user=给用户看的提问

llm_kwargs, chatbot,

history=["The main idea of the previous section is?", last_iteration_result], # 迭代上一次的结果

- sys_prompt="Extract the main idea of this section." # 提示

+ sys_prompt="Extract the main idea of this section.用中文回答我" # 提示

)

iteration_results.append(gpt_say)

last_iteration_result = gpt_say

From cd9f2ec402f952b0a112f1f71c19f00c90697648 Mon Sep 17 00:00:00 2001

From: binary-husky <96192199+binary-husky@users.noreply.github.com>

Date: Wed, 1 Nov 2023 22:25:27 +0800

Subject: [PATCH 4/6] Update README.md

---

README.md | 2 +-

1 file changed, 1 insertion(+), 1 deletion(-)

diff --git a/README.md b/README.md

index 83f385c9..60e7be15 100644

--- a/README.md

+++ b/README.md

@@ -61,7 +61,7 @@ Latex论文一键校对 | [函数插件] 仿Grammarly对Latex文章进行语法

- 新界面(修改`config.py`中的LAYOUT选项即可实现“左右布局”和“上下布局”的切换)

-

+

GPT 学术优化 (GPT Academic)

-7. 新增MOSS大语言模型支持

-

-7. 新增MOSS大语言模型支持

- -

- +

+